Odpowiedzialność karna sztucznej inteligencji

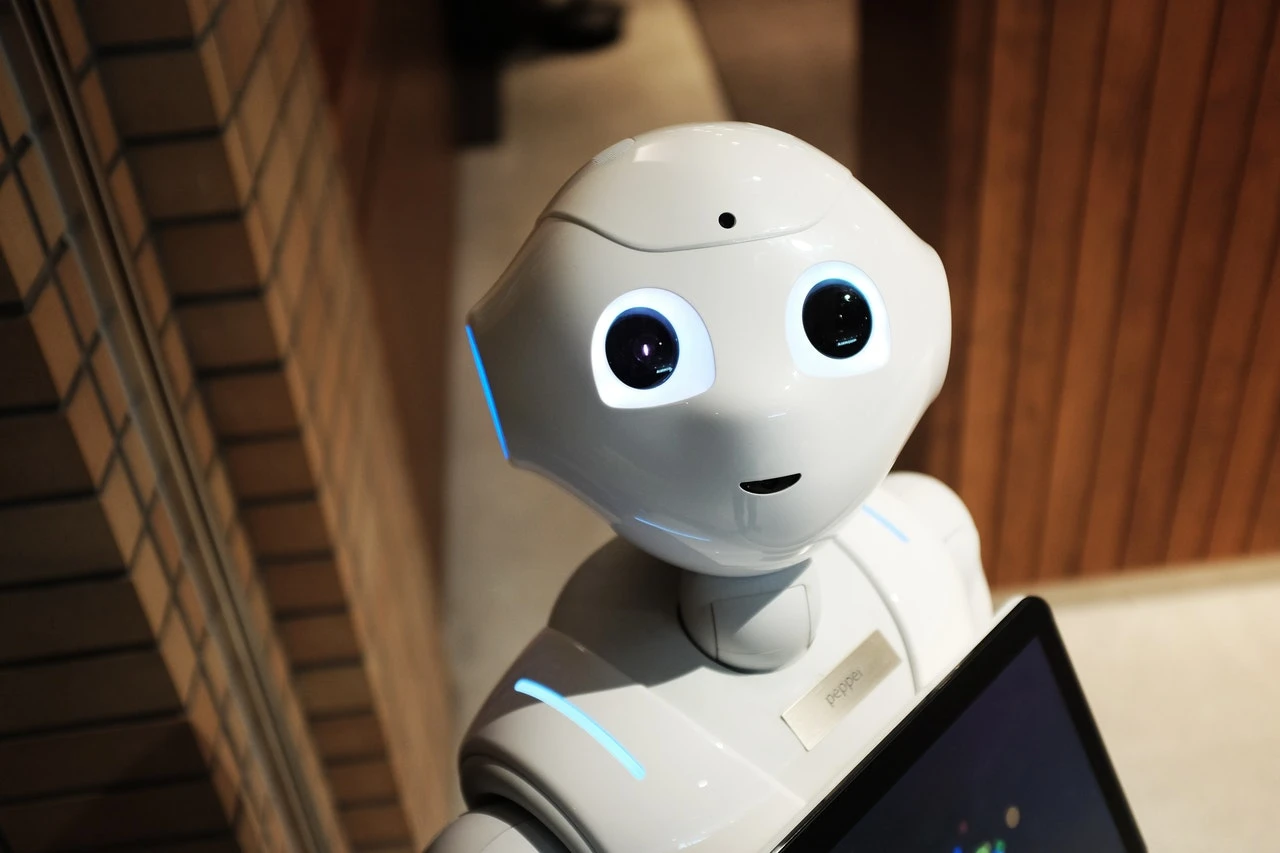

Definicje sztucznej inteligencji zazwyczaj albo są zbyt złożone by każdy zrozumiał istotę bytu, bądź też - co cechuje większość definicji SI - zbyt personifikują sztuczną inteligencję. Większość definicji traktuje bowiem SI jako dziedzinę informatyki, która zajmuje się naśladowaniem ludzkiego myślenia.

To dosyć mylące, bo personifikowanie sztucznej inteligencji, a nawet swego rodzaju utożsamianie "myślenia" programu komputerowego z myśleniem ludzkim - jest błędem. Wydaje się, że odpowiednią definicję sztucznej inteligencji - przynajmniej w świetle rozważań prawnych - prezentuje T. Zalewski w "Prawie sztucznej inteligencji" (L. Lai, M. Świerczewski, C.H. Beck, wyd. 2020). Uznaje on, że sztuczną inteligencją jest

Takie myślenie wydaje się lepiej oddawać istotę sztucznej inteligencji. To jest tylko program komputerowy, a nie byt, który powstaje "na podobieństwo człowieka". Oczywiście powyższa definicja będzie wymagała przebudowania w momencie wytworzenia samoświadomej sztucznej inteligencji (AGI).

Relacja sztucznej inteligencji do prawa karnego

Przestępstwem jest - w rozumieniu polskiego prawa karnego - bezprawny, zawiniony, szkodliwy w stopniu wyższym niż znikomy i zabroniony przez ustawę w dacie popełnienia czyn człowieka. Michael S. Moore tłumaczy zarazem - to amerykański profesor prawa, ale treść jego artykułu dot. źródeł prawa karnego ma wartość uniwersalną - że prawo karne ma ponadto źródło moralne i metafizyczne.

Można to rozumieć tak, że przestępstwem jest czyn człowieka (odpowiednio dojrzałego i poczytalnego w dacie jego popełnienia, a ponadto zaznajomionego z obowiązującym kodem moralnym), bo człowiek ma "duszę i moralność". Personifikacja sztucznej inteligencji bardzo często powoduje, że nadajemy jej jakąś świadomość. Determinuje to pewną chęć - w wypadku na przykład potrącenia człowieka przez autonomiczny samochód - reakcji karnej.

Takie rozszerzanie moralności na byty niebędące człowiekiem miało już miejsce - w średniowieczu. Warto przypomnieć choćby proces maciory z Falais, o którym pisała m.in. Rzeczpospolita, gdzie w XIV wieku uznano świnię winną pogryzienia dziecka. Maciorę zatrzymano, trzymano w areszcie, przesłuchiwano (milczenie uznano za przyznanie się do winy), a następnie publicznie zabito w formie egzekucji. Zdarzenie musiały obserwować okoliczne zwierzęta, by się nauczyły odpowiedniego postępowania. Na ziemiach polskich - co wynikało ze Zwierciadła Saskiego - karano nawet rzeczy. Tak też budynek, w którym doszło do zgwałcenia, był burzony ze względu na to, że uniemożliwił ofierze ucieczkę.

Wspominam o tym dlatego, by wskazać, że takie nieprawnicze, intuicyjne rozumowanie przestępstwa i prawa karnego "siedzi w człowieku" i dotyczy w zasadzie jakiegokolwiek bytu, jakkolwiek związanego z moralnie nagannym skutkiem. Podobne rozumowanie - oparte na swoistym prawie naturalnym - wydają się stosować nierzadko osoby komentujące wyroki sądowe, które dziwią się, że sprawca nieumyślnego wypadku drogowego nie odpowiada za zabójstwo z art. 148 Kodeksu karnego.

Czy sztuczna inteligencja jest obojętna dla prawa?

Sztuczna inteligencja nie jest obojętna dla polskiego prawa karnego. Oczywiście samej SI nie można pociągnąć do odpowiedzialności karnej. Sama w sobie może być jednak narzędziem w rękach człowieka, które ten (świadomie lub nie) wykorzystuje do popełnienia czynu zabronionego.

Sztuczna inteligencja może być także przedmiotem przestępstwa - na przykład przestępstw przeciwko własności intelektualnej. Odnosząc się do postulatów de lege ferenda zgodzić się należy z poglądami doktryny. Dopóki nie powstanie świadoma sztuczna inteligencja, dopóty należy uznać, że jest to - podobnie do zwierzęcia - narzędzie. Niewykluczone zatem, że konieczne będą typy kwalifikowane przestępstw - jak niedopilnowanie, by autonomiczny pojazd nie spowodował wypadku.

Warto jednak pamiętać, że sztuczna inteligencja najpierw powstała w umysłach ludzi (jako elektroniczna kopia człowieka), potem zaś zaczął się jej faktyczny rozwój. Jak na razie pojmowanie SI rodem z science fiction nie ma żadnych podstaw w rzeczywistości.

Nie znaczy to jednak, że rozwój się zatrzymał - wręcz przeciwnie. Pamiętajmy jednak, że dzisiaj mówimy o programie komputerowym. Odpowiedzialność karna sztucznej inteligencji jeszcze nie istnieje - co jest niewątpliwe.