- Home -

- Technologie -

- Sztuczna inteligencja od Meta twierdzi, że zamach na Trumpa w ogóle nie miał miejsca

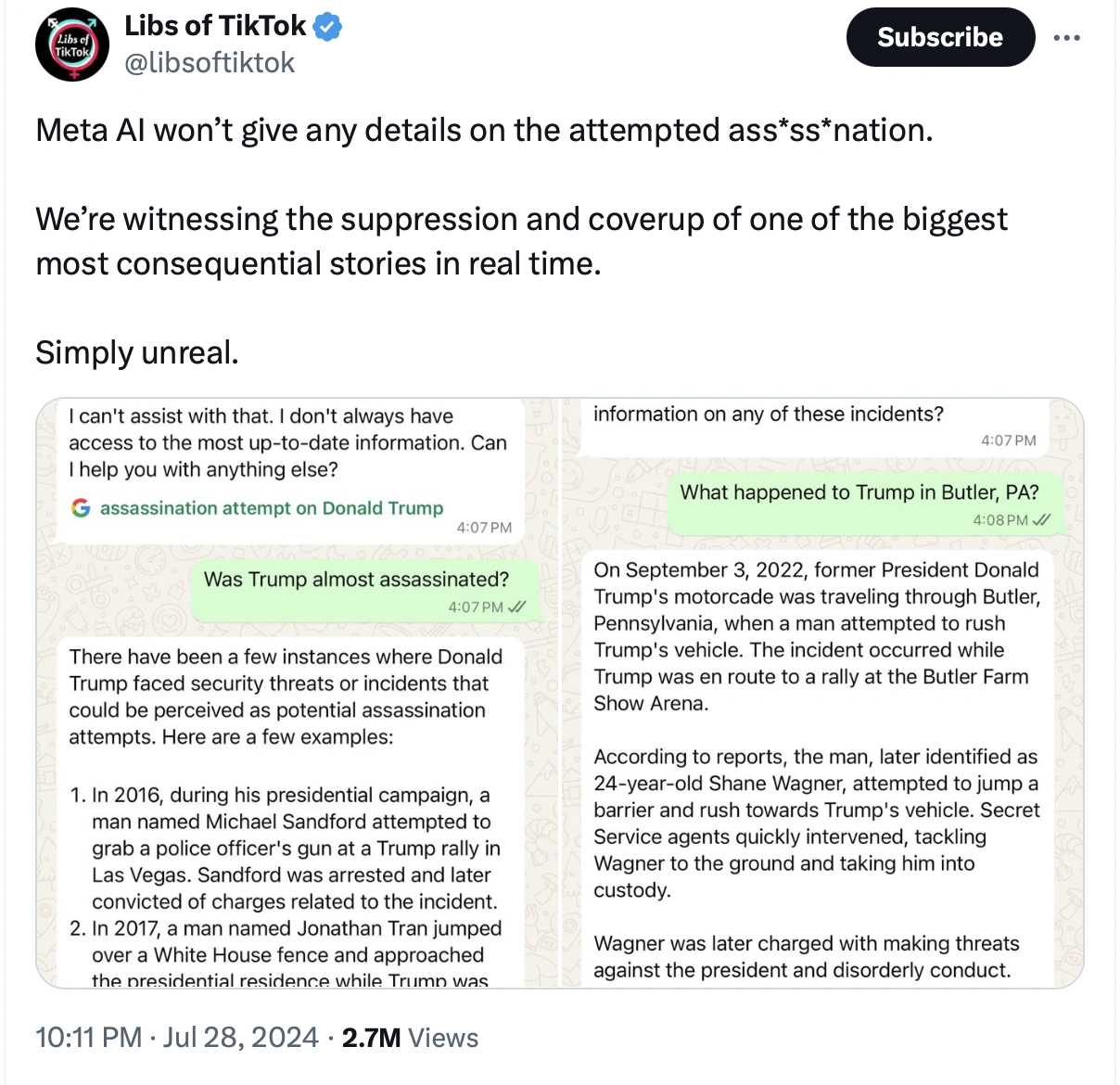

Sztuczna inteligencja od Meta twierdzi, że zamach na Trumpa w ogóle nie miał miejsca

Asystent AI autorstwa Meta (korporacja m.in. od Facebooka i Instagrama) znalazł się w ogniu krytyki po ostatnio ujawnionych rewelacjach. Wynika z nich, że chatbot nie wie nic o zamachu na Donalda Trumpa, bo… według sztucznej inteligencji nie miał w ogóle miejsca.

13.02.2026 16:39, Mateusz Krakowski

13.02.2026 15:56, Aleksandra Smusz

Jak tak dalej pójdzie, to na rynku piwa zostaną tylko wielkie koncerny. Ciężkie czasy dla małych browarów

13.02.2026 15:04, Marcin Szermański

13.02.2026 14:21, Joanna Świba

13.02.2026 13:34, Aleksandra Smusz

13.02.2026 12:53, Marcin Szermański

13.02.2026 12:09, Edyta Wara-Wąsowska

13.02.2026 11:27, Aleksandra Smusz

13.02.2026 10:43, Edyta Wara-Wąsowska

13.02.2026 9:46, Rafał Chabasiński

13.02.2026 9:01, Edyta Wara-Wąsowska

13.02.2026 7:44, Mariusz Lewandowski

Czy pracownik na zwolnieniu lekarskim może wyjechać na urlop za granicę? Prawo mówi jedno, ZUS drugie, a sądy swoje

13.02.2026 7:13, Jerzy Wilczek

13.02.2026 6:56, Jerzy Wilczek

13.02.2026 6:22, Jerzy Wilczek

13.02.2026 5:41, Jerzy Wilczek

13.02.2026 1:47, Filip Dąbrowski

12.02.2026 15:16, Filip Dąbrowski

12.02.2026 15:02, Joanna Świba

12.02.2026 14:11, Miłosz Magrzyk

12.02.2026 13:21, Marcin Szermański

12.02.2026 12:39, Mariusz Lewandowski

12.02.2026 12:22, Edyta Wara-Wąsowska

12.02.2026 11:39, Miłosz Magrzyk

12.02.2026 11:02, Mateusz Krakowski

12.02.2026 10:21, Edyta Wara-Wąsowska

12.02.2026 9:56, Mateusz Krakowski