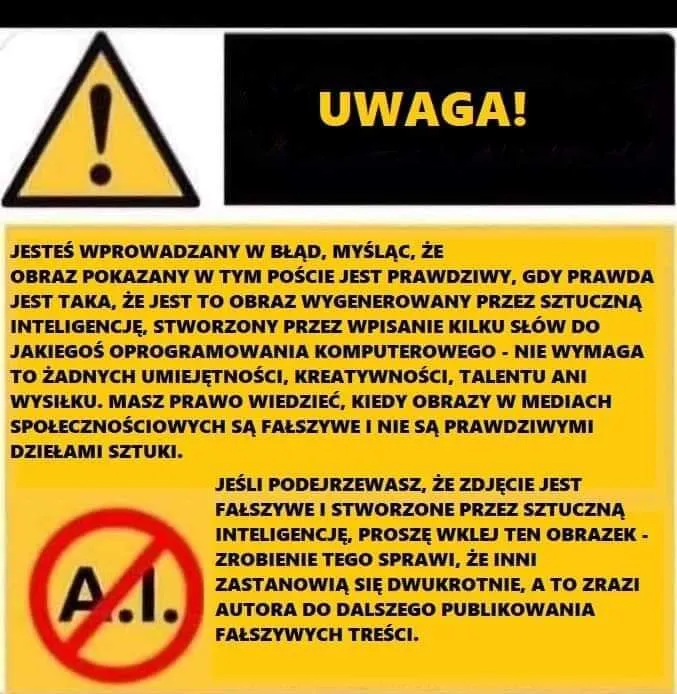

Przykładem takich działań jest publikowanie specjalnych komunikatów pod obrazami lub filmami wygenerowanymi przez sztuczną inteligencję, aby informować o potencjalnym zagrożeniu. W załączonym kilka akapitów niżej obrazku, jeden z takich komunikatów ostrzega użytkowników przed treściami tworzonymi przez AI, wyjaśniając, że mogą one wprowadzać w błąd i nie są prawdziwymi dziełami sztuki.

Problem AI, który narasta

Osoby starsze, szczególnie te mniej zaznajomione z nowymi technologiami, są bardziej narażone na nieświadome konsumowanie treści stworzonych przez AI. Wynika to głównie z braku wiedzy o tym, jak funkcjonują narzędzia sztucznej inteligencji oraz trudności w odróżnieniu prawdziwego obrazu czy wideo od tego, co zostało wygenerowane komputerowo. Problem ten może prowadzić do dezinformacji, wprowadzania w błąd oraz manipulacji emocjami odbiorców.

Starsze osoby często polegają na mediach społecznościowych i komunikatorach jako głównych źródłach informacji. Niestety, w świecie, gdzie technologia pozwala na tworzenie coraz bardziej realistycznych deepfake’ów, fałszywych newsów oraz zmanipulowanych obrazów, te grupy są szczególnie podatne na oszustwa. Fałszywe wiadomości, które krążą w internecie, mogą wywoływać panikę, dezinformację, a nawet wpływać na decyzje życiowe czy polityczne.

No dobrze, jak działa ten oddolny ruch oporu?

Internauci, zdając sobie sprawę z powagi sytuacji, rozpoczęli kampanię edukacyjną, której celem jest zwiększenie świadomości na temat zagrożeń związanych z treściami generowanymi przez AI. Przykładem jest inicjatywa, gdzie pod każdą podejrzaną grafiką lub filmem pojawia się odpowiedni komunikat ostrzegający, informujący o potencjalnie fałszywym charakterze treści. Tego typu ostrzeżenia mogą nie tylko zwrócić uwagę na problem, ale też skłonić innych użytkowników do krytycznego podejścia do treści, które konsumują.

Wspomniany wcześniej komunikat, który pojawia się na przykład na Facebooku czy Instagramie, podkreśla, że obrazy tworzone przez sztuczną inteligencję nie wymagają umiejętności artystycznych, kreatywności ani wysiłku. Chociaż AI może tworzyć zachwycające grafiki, należy pamiętać, że nie są one efektem tradycyjnego procesu twórczego, co dla wielu osób starszych może być trudne do zrozumienia. Ostrzeżenia te mają na celu zachęcenie do ostrożności i krytycznego myślenia podczas przeglądania treści w mediach społecznościowych.

Dlaczego to ważne?

Dla starszych ludzi, którzy nie dorastali z nowoczesnymi technologiami, świat cyfrowy bywa trudny do nawigowania. Wielu z nich czerpie informacje z internetu, nie zawsze zdając sobie sprawę z możliwości manipulacji treściami. Fałszywe obrazy i wideo mogą prowadzić do nieporozumień, wpływać na decyzje finansowe, a nawet podważać zaufanie do instytucji publicznych. Deepfake’i mogą być wykorzystywane do oszustw, na przykład tworząc fałszywe wiadomości od bliskich osób, co może prowadzić do utraty pieniędzy lub emocjonalnego stresu.

To właśnie dlatego ruch oporu przeciwko AI koncentruje się na edukacji i ostrzeganiu. Im więcej ludzi zdaje sobie sprawę z zagrożeń związanych z treściami generowanymi przez AI, tym trudniej jest szerzyć fałszywe informacje. Szczególnie ważne jest tutaj zaangażowanie młodszych pokoleń, które mogą wspierać swoich starszych krewnych, ucząc ich, jak rozpoznawać nieprawdziwe treści i unikać dezinformacji.

To bardzo fajna oddolna inicjatywa!

Choć technologia sztucznej inteligencji będzie się nadal rozwijać, ruchy takie jak ten mogą pomóc w minimalizowaniu jej negatywnych skutków. Społeczności internetowe, działając wspólnie, mogą tworzyć strategie, które pozwolą na skuteczniejsze identyfikowanie i oznaczanie treści stworzonych przez AI. W przyszłości, możemy spodziewać się bardziej zaawansowanych narzędzi, które będą w stanie automatycznie wykrywać deepfake’i i informować użytkowników o tym, co jest prawdziwe, a co nie.

Obserwuj nas w Google Discover

Podobają Ci się nasze treści?

Google Discover