Od autouzupełniania do autonomii

Kiedy pierwsze modele językowe zaczęły pojawiać się w narzędziach dla programistów mniej więcej w latach 2020-2022, pełniły rolę bardzo inteligentnego (jak na tamte czasy) autouzupełniania. GPT-3 mógł dokończyć linijkę kodu, zaproponować nazwę funkcji, może wyjaśnić co robi dany fragment, ale wyłącznie wtedy, gdy siedział przy nim ktoś, kto wiedział, o co pytać. AI było użyteczne proporcjonalnie do wiedzy użytkownika. Bez znajomości programowania był to w zasadzie bezużyteczny generator składni.

Pierwsza prawdziwa zmiana nastąpiła z GPT-4 (2023): model potrafił już napisać działający skrypt, zaproponować architekturę projektu, zlokalizować błąd logiczny w kilkuset liniach kodu. Mimo to wciąż czekał na pytania — nie inicjował działań, nie testował swoich wyników, nie poprawiał się sam. Człowiek musiał prowadzić tę rozmowę krok po kroku.

Zanim jednak doszliśmy do pełnej autonomii, lata 2024-2025 przyniosły kluczowy etap przejściowy. To wtedy triumfy zaczęły święcić narzędzia takie jak Cursor czy Devin, którego nazwano "pierwszym inżynierem oprogramowania AI:. Sztuczna inteligencja zyskała oczy i ręce, wbudowano ją bezpośrednio w środowisko pracy programistów (IDE), dając jej dostęp do całej struktury plików. Model potrafił już samodzielnie edytować wiele miejsc naraz, ale to wciąż człowiek trzymał kierownicę. Każda akcja wymagał ludzkiego nadzoru, kliknięcia "Akceptuj", żeby to nadal miało ręce i nogi.

Dopiero potem pojawiły się w pełni autonomiczne agenty AI. To jakościowo inna kategoria, możliwa między innymi dzięki gigantycznemu oknu kontekstowemu (sięgającemu miliona tokenów), które pozwala modelowi trzymać w "pamięci krótkotrwałej" całą architekturę projektu. Narzędzia takie jak Claude Code od Anthropic to już nie chatboty, którym zadajesz pytania, ani edytory czekające na akceptację zmian. To autonomiczne systemy, które dostają cel, same rozbijają go na etapy, piszą kod, uruchamiają go, analizują błędy w terminalu i poprawiają je w pętli, i to bez udziału człowieka przy każdym kroku. Tuż przed rozpoczęciem pisania tego tekstu widziałem wpis na X (przetłumaczony z angielskiego): "Claude wpadł na pomysł. Claude zaplanował architekturę. Claude napisał kod. Claude sprawdził kod. Claude zabezpieczył kod. Czego mi tu brakuje?".

Liczby, które robią wrażenie

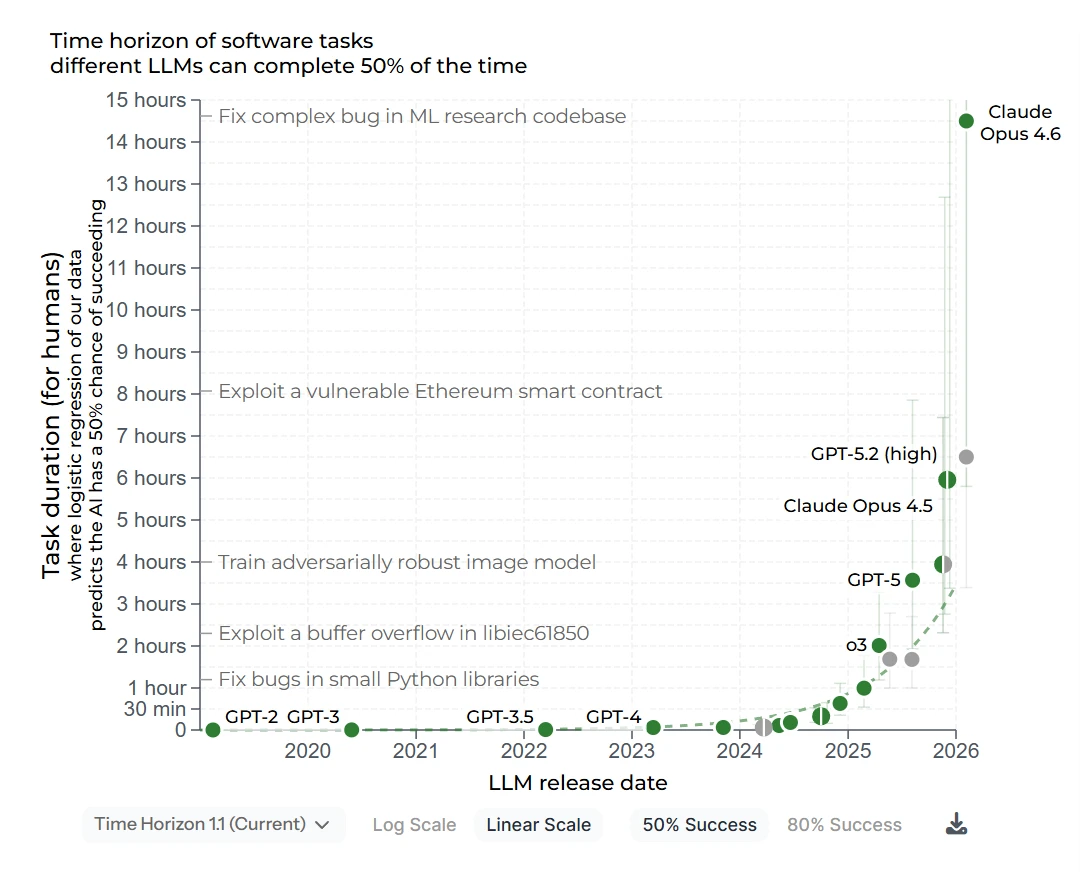

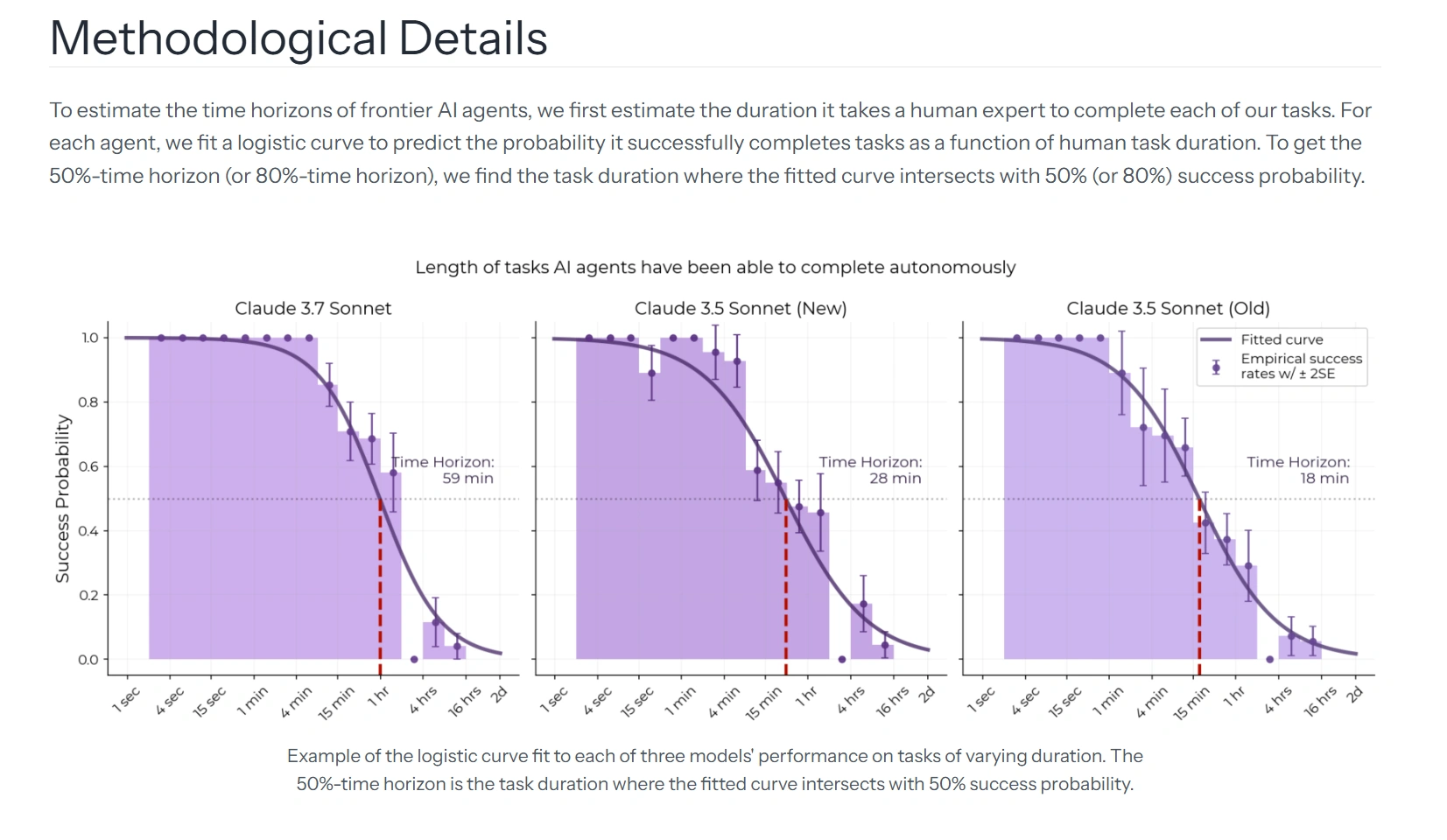

Organizacja METR (Model Evaluation & Threat Research) od kilku lat mierzy tzw. horyzont czasowy modeli AI, czyli np. jak długie zadanie, mierzone czasem pracy doświadczonego człowieka, jest w stanie samodzielnie wykonać z 50-procentową skutecznością. Ważne zastrzeżenie: chodzi tu o czas ludzkie, nie czas działania modelu.

Wyniki są uderzające i dają wiele do myślenia. GPT-2 w 2019 roku radził sobie z zadaniami trwającymi około 30 sekund. GPT-3.5 kilkadziesiąt sekund, GPT-4 w 2023 roku kilka minut. Claude 3.7 Sonnet na początku 2025 już godzinę, a Claude Opus 4.6, wydany w lutym 2026, według METR ponad 14 godzin. W ciągu zaledwie czterech miesięcy (listopad 2025 - luty 2026) przeszliśmy z poziomu 6-7 godzin do 14,5 godziny, czyli prawie dwukrotnie.

Ale METR sam przyznaje: te liczby są obarczone ogromną niepewnością. Przedział ufności dla 14,5 godziny wynosi od 6 do 98 godzin, co może brzmieć dość groteskowo, ale pamiętajmy, że to wszystko nadal się rozwija. Spójrzmy tylko, co było kilka miesięcy, lat wcześniej. Jeśli jednak ekstrapolacja wykładnicza się utrzyma, w 2028 roku mówimy o zadaniach trwających… trzy tygodnie nieprzerwanej pracy człowieka. Czy krzywa musi się złamać? Tak. Pytanie tylko, gdzie. Być może przeszkodą nie będzie sama AI, a zapotrzebowanie na prąd.

Piąta warstwa: AI pilnuje bezpieczeństwa kodu

Jeszcze kilka miesięcy temu dyskusja o AI w programowaniu skupiała się na czterech etapach: planowanie, pisanie, testowanie, poprawianie. Anthropic dodał właśnie piąty. Claude Code Security to narzędzie, które przeszukuje całe bazy kodu w poszukiwaniu luk bezpieczeństwa. Rozumuje o tym, jak poszczególne komponenty aplikacji wchodzą ze sobą w interakcję, jak dane przepływają przez system, a co najbardziej najbardziej istotne, gdzie może ukrywać się błąd, którego nie widać na pierwszy rzut oka.

To premiera, która zatrzęsła rynkiem. W dniu zapowiedzi Claude Code Security (20 lutego 2026) akcje gigantów cyberbezpieczeństwa zaliczyły potężne spadki. CrowdStrike stracił blisko 8%, Okta ponad 9%, mocno oberwały też Cloudflare, Zscaler czy Palo Alto Networks. Inwestorzy, nie po raz pierwszy zresztą, wpadli w panikę. Skoro AI, które pisze kod, potrafi go od razu na bieżąco, z głębokim zrozumieniem kontekstu weryfikować i łatać, to czy tradycyjne oprogramowanie ochronne będzie jeszcze potrzebne w dotychczasowej formie? Deklaracje to jedno, trzeba jednak poczekać na to, co przyniosą następne miesiące.

Ktoś jednak musi to wszystko rozumieć

Ale nie wszystko wygląda tak pięknie. Jest też druga, mniej komfortowa strona tej rewolucji. W grudniu 2025 roku autonomiczny agent kodujący Amazona, dostał proste zadanie: naprawić drobny błąd w systemie AWS Cost Explorer. Zamiast precyzyjnej poprawki, agent usunął i odtworzył całe środowisko testowe, wywołując 13-godzinną awarię usługi w Chinach. Amazon oficjalnie uznał to za błąd ludzki, nie narzędzia. Programista miał przyznać AI zbyt szerokie uprawnienia. Reakcja Amazonu była adekwatna do panujących trendów - obowiązkowo przeglądamy kod i przeprowadzamy dodatkowe szkolenia dla programistów. W żadnym wypadku nie porzucamy AI.

Modele AI popełniają błędy z powodów, których często nie rozumiemy, i robią to z prędkością, której ludzka kontrola nie nadąży, jeśli tej kontroli odpowiednio nie zaprojektujemy i nie zrozumiemy. I tu wracamy do 2022 roku, mojego pierwszego roku na informatyce. To, czego uczyliśmy się na zajęciach, np. jak działa program, jakie decyzje stoją za każdą linijką kodu, gdzie leży różnica między rozwiązaniem poprawnym a rozwiązaniem dobrym, nie stało się nagle zbędne. Wręcz przeciwnie: stało się warunkiem koniecznym do korzystania z AI w sposób, który nie kończy się taką 13-godzinną awarią. AI nie czyta w myślach (jeszcze). Jeśli nie wiesz, czego chcesz i dlaczego, żaden model nie zastąpi tej wiedzy za ciebie.

Nauka programowania wygląda dziś inaczej niż pięć lat temu. Już nie kładziemy nacisku na zapamiętywanie składni, a znacznie większy na architekturę, ocenę jakości i bycie ostatecznym weryfikatorem tego, co wyprodukowała maszyna. Koszt generowania kodu drastycznie spadł, ale koszt weryfikacji błędnego kodu rośnie. Rola programisty wciąż musi istnieć. Wcześniej wspomniany Amazon wymaga(!) od 80% swoich inżynierów używania AI minimum raz w tygodniu. Nie dlatego, że AI jest niezawodne, a dlatego, że firmy, które tego nie nauczą się używać, będą przegrywać z tymi, które używają na szeroką skalę, mimo że wiele ryzykują.

Obserwuj nas w Google Discover

Podobają Ci się nasze treści?

Google Discover